Desbloqueando el potencial de los modelos de aprendizaje profundo con Raspberry Pi 5

Créditos de la imagen: Kiwi Electronics

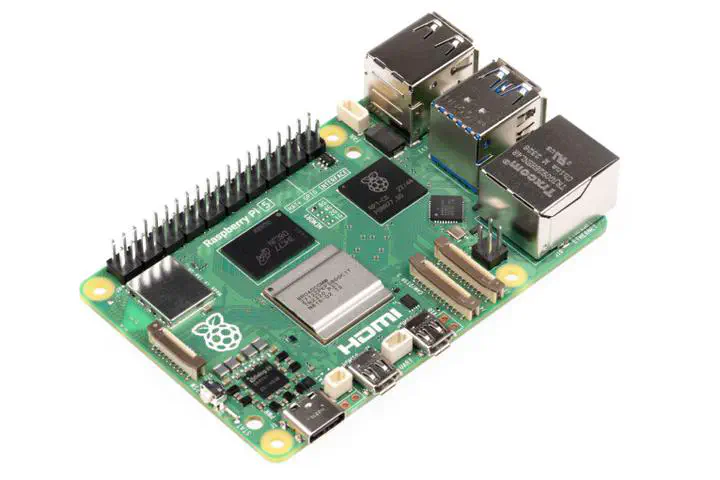

Créditos de la imagen: Kiwi ElectronicsEn Training Data Lab, nos enfocamos en desarrollar soluciones innovadoras que combinen la potencia del aprendizaje profundo y la eficiencia energética. Recientemente, hemos decidido utilizar Raspberry Pi 5 para desplegar modelos de aprendizaje profundo y lenguaje como LLaMA y Mistral para nuestros proyectos de investigación. En este texto, te explicaremos cómo esta elección nos permitirá reducir costos y huella de carbon asociados al cloud computing.

El problema: La dependencia del cloud computing

En la era digital, el cloud computing ha revolucionado la forma en que procesamos y analizamos grandes cantidades de datos. Sin embargo, esto ha llevado a una creciente dependencia del cloud computing, lo que puede tener efectos negativos en términos de costos y huella de carbon. Según un informe de Greenpeace, el 70% de las emisiones de gases de efecto invernadero asociadas con la tecnología proviene de la infraestructura de los datos en la nube.

La solución: Raspberry Pi 5

En busca de una solución más sostenible y eficiente, hemos decidido utilizar Raspberry Pi 5 para desplegar nuestros modelos de aprendizaje profundo y lenguaje a cargo de nuestro investigador Bastián González-Bustamante. Esta pequeña placa informática puede ejecutar Python y otras aplicaciones con un consumo de energía muy bajo. Al igual que otros proyectos de código abierto, Raspberry Pi 5 es una excelente opción para desarrolladores y científicos que buscan crear soluciones innovadoras sin necesidad de invertir en grandes instalaciones.

LLaMA y Mistral: Modelos de aprendizaje profundo

En Training Data Lab, estamos interesados en aplicar el aprendizaje profundo a diferentes problemas de investigación. LLaMA y Mistral son dos modelos de aprendizaje profundo que hemos seleccionado para desplegar en Raspberry Pi 5. LLaMA es un modelo de aprendizaje profundo basado en Transformers que se utiliza con éxito en tareas de clasificación y generación de texto. Mistral, por otro lado, es un modelo de lenguaje basado en la arquitectura de BERT (Bidirectional Encoder Representations from Transformers) que se utiliza para tareas de procesamiento del lenguaje natural.

Ventajas de utilizar Raspberry Pi 5

La elección de Raspberry Pi 5 nos permite disfrutar de varias ventajas:

- Costos reducidos. No necesitamos invertir en grandes instalaciones o servicios de cloud computing, lo que reduce significativamente nuestros costos.

- Eficiencia energética. Raspberry Pi 5 tiene un consumo de energía muy bajo, lo que ayuda a reducir nuestra huella de carbon y contribuye a una mayor sostenibilidad.

- Flexibilidad. Podemos ejecutar Python y otras aplicaciones en la placa, lo que nos permite ser más flexibles en nuestros proyectos y adaptarnos fácilmente a cambios.

- Colaboración. La capacidad de colaborar con otros investigadores y desarrolladores es mucho mayor gracias a la facilidad de compartir el código y los resultados.

Conclusión

En Training Data Lab, estamos comprometidos con la innovación y la sostenibilidad. Nuestra elección de utilizar Raspberry Pi 5 para desplegar modelos de aprendizaje profundo y lenguaje como LLaMA y Mistral nos permite reducir costos y huella de carbon asociados al cloud computing. Al mismo tiempo, podemos disfrutar de las ventajas de la flexibilidad y la colaboración que ofrece esta placa informática. Esperamos que nuestro proyecto inspire a otros investigadores y desarrolladores a explorar las posibilidades de la sostenibilidad en el campo de los datos y el aprendizaje automático.

* Texto generado por AI

Lee más acerca de cómo generamos nuestros contenidos